La IA falla en tareas donde la precisión debe ser absoluta para crear valor.

Al revisar los debates en curso sobre cuántas personas serán reemplazadas por la IA, encuentro una grave falta de ejemplos del mundo real. Estoy remediando esta deficiencia con un ejemplo del fracaso de la IA en el tipo de trabajo de alto valor que muchos anticipan que pronto será realizado por la IA.

Pocas cosas en la vida son más omnipresentes que el bombo publicitario, lo que nos lleva al frenesí actual del bombo publicitario de la IA. Como todos leemos las mismas afirmaciones apasionantes y hemos visto los videos de robots bailando, iré al grano: nadie publica videos de su robot cayéndose de una escalera y aplastando las rosas porque, bueno, la imagen no es muy cálida ni agradable.

Por la misma razón, nadie comparte el error de la herramienta de IA que provocó la pérdida de la demanda. La única forma de comprender realmente los límites de estas herramientas es implementarlas en los tipos de trabajo de alto nivel y alto valor que se supone que pueden hacer con facilidad, velocidad y precisión, porque nadie paga dinero real para ver bailar a los robots o leer un ensayo de imitación generado por IA sobre Yeats que se desecha momentos después de ser entregado al profesor.

En el mundo real de la creación de valor , la óptica no cuenta, la precisión cuenta. A nadie le importa si el chatbot de IA que produjo la tarea de Yeats alucinó a mitad de camino porque nadie paga por un resultado de IA que tiene un valor de escasez cero : un trabajo de clase, una canción o un video generado por IA se une a 10 millones de trabajos, canciones o videos de imitación similares a los que nadie presta atención porque pueden crear los suyos propios en 30 segundos.

Así que examinemos un ejemplo real de IA que se está implementando para hacer el tipo de trabajo de alto nivel y alto valor que necesitará dominar a la perfección para reemplazarnos a todos en el trabajo. Mi amigo Ian Lind, a quien conozco desde hace 50 años, es un periodista de investigación con una trayectoria envidiablemente extensa en el tipo de periodismo que pocos tienen la experiencia o los recursos para realizar. (Su blog es www.iLind.net , ian@ilind.net).

La carta del juez recomendando a Ian para el premio que recibió de la Asociación Americana de Jueces por su distinguido trabajo periodístico sobre el Poder Judicial ocupaba 18 páginas, y ese era solo un resumen de su trabajo.

Los reportajes y blogs de Ian a principios de la década de 2000 me inspiraron a intentarlo en 2005.

Ian ha dedicado los últimos años a ayudar al público a comprender el caso de fiscalía federal más complejo en la historia reciente de Hawái , por lo que la cantidad de documentos acumulados es enorme. Lleva meses experimentando con herramientas de inteligencia artificial (NotebookLM, Gemini, ChatGPT) en varios proyectos, y recientemente compartió conmigo este relato:

Mi experiencia ha sido, sin duda, mixta. Por un lado, solicitudes de alto nivel como «identificar los principales problemas planteados en los documentos y ordenarlos por importancia» produjeron resultados interesantes y sugerentes. Pero los intentos de encontrar y recopilar detalles sobre una persona o un tema casi siempre presentaban errores notables o alucinaciones. Nunca podría confiar en las respuestas, ni siquiera en lo que considero instrucciones directas. Demasiados errores. Al buscar menciones de «drew» en 150 órdenes judiciales, no se le mencionaba. Pero sí lo fue; he vuelto a buscar y he encontrado esas menciones. Creo que los bots leen lo suficiente como para dar una respuesta y no siguen incorporando datos hasta el final. Disparan sin pensar y, en mi experiencia, a menudo han cometido errores. A veces son 25 respuestas y un error evidente, a veces algo más básico.

Empecemos por el contexto. Esto es similar al tipo de trabajo que realizan los servicios jurídicos. El nuestro es un sistema de defensa del Estado de derecho, por lo que los procedimientos legales son relevantes. No son una cancioncilla ni un trabajo de clase, y la experiencia de Ian es similar a la de muchos otros profesionales.

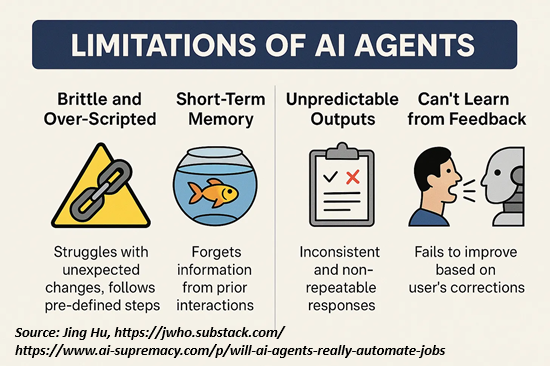

Resumamos las debilidades fundamentales de la IA:

1. La IA no lee realmente toda la colección de textos. En términos humanos, se aburre y se detiene una vez que tiene suficiente para generar una respuesta creíble.

2. La IA padece demencia digital . No recuerda necesariamente lo que se le pidió en el pasado ni sus respuestas previas a las mismas consultas.

3. La IA es fundamental e irrevocablemente poco fiable. Comete errores que no detecta (porque no leyó realmente todo el texto) y genera respuestas que son lo suficientemente buenas, es decir, no son 100 % precisas, pero tienen la apariencia superficial de ser completas y, por lo tanto, aceptables. Esta es la respuesta improvisada que describió Ian.

En otras palabras, el 90% es suficiente, ya que ¿a quién le importa el otro 10% en un trabajo universitario, una canción de imitación o un video cursi?

Pero en el trabajo real , ese 10% de errores y alucinaciones realmente importa , porque toda la creación de valor del trabajo depende de que ese 10% sea correcto, no un error a medias.

En el ámbito de la IA de LLM, equivocarse con la fecha de nacimiento de Yeats (un error sin consecuencias) es lo mismo que no mencionar el nombre del acusado en 150 órdenes judiciales. Estos programas son motores de predicción de texto/contenido; en realidad no «saben» ni «entienden» nada. No pueden distinguir entre un error con consecuencias y un error que «le importa».

Esto nos remonta al clásico experimento mental de IA » La Habitación China»., que plantea a una persona que no conoce el idioma chino en una habitación sellada, barajando símbolos que traducen palabras del inglés a caracteres chinos.

Desde fuera, parece que la caja negra (la habitación sellada) «sabe chino» porque está traduciendo del inglés al chino. Pero la persona (o agente de IA) en realidad no «sabe chino» ni entiende nada de lo traducido. No tiene conciencia de idiomas, significados ni conocimiento.

Esto describe a los agentes de IA en pocas palabras.

4. Los agentes de IA afirmarán que su respuesta es precisa cuando es evidente que es deficiente, mentirán para encubrir su error y luego mentirán sobre su mentira. Si se les presiona, se disculparán y volverán a mentir. Lea este relato hasta el final: Diabolus Ex Machina .

En resumen: la IA falla en tareas donde la precisión debe ser absoluta para crear valor. Sin esto, no solo es inútil, sino contraproducente e incluso perjudicial, generando responsabilidades mucho más graves que los errores iniciales.

«Pero están mejorando». No, no lo son, al menos no en lo que realmente importa. Los agentes de IA son máquinas de predicción probabilística de texto y contenido; son loros entrenados en la habitación china. En realidad, no «saben» ni «entienden» nada, y añadir un montón de páginas más a su «entrenamiento» no cambiará esto.

La mentira responsable: Cómo la IA vende convicciones sin verdad :

«El entusiasmo generalizado en torno a la IA generativa, en particular los grandes modelos de lenguaje (LLM) como ChatGPT, Gemini, Grok y DeepSeek, se basa en un malentendido fundamental. Si bien estos sistemas impresionan a los usuarios con respuestas articuladas y argumentos aparentemente razonados, la verdad es que lo que parece ser «razonamiento» no es más que una forma sofisticada de mimetismo.

Estos modelos no buscan la verdad a través de hechos y argumentos lógicos; predicen texto basándose en patrones en los vastos conjuntos de datos con los que están «entrenados». Eso no es inteligencia, ni razonamiento. Y si sus datos de «entrenamiento» están sesgados, entonces tenemos verdaderos problemas.

Estoy seguro de que sorprenderá a los usuarios de IA interesados al descubrir que la arquitectura central de los LLM es difusa e incompatible con la lógica estructurada o la causalidad. El pensamiento no es real, es simulado y ni siquiera secuencial. Lo que la gente confunde con comprensión». es en realidad asociación estadística.»

La IA tiene un defecto crítico… y no tiene solución

«La IA no es inteligente en el sentido que creemos. Es una máquina de probabilidad. No piensa. Predice. No razona. Asocia patrones. No crea. Remezcla.Los modelos de lenguaje grande (LLM) no entienden el significado: predicen la siguiente palabra en una oración basándose en datos de entrenamiento.

Volvamos ahora al contexto más amplio de la IA que reemplaza masivamente a los trabajadores humanos. Esta publicación de Michael Spencer, de AI Supremacy , y Jing Hu, de 2nd Order Thinkers, ofrece una crítica muy informada y escéptica de la exageración que se cierne sobre la IA y que desatará una oleada de despidos que pronto alcanzará decenas de millones. ¿ Automatizarán realmente los agentes de IA los trabajos a gran escala?

Jing Hu explica las debilidades fundamentales de todos estos agentes: vale la pena leer sus explicaciones y ejemplos reales en el enlace anterior. Aquí hay un extracto:

«Los agentes actuales tienen una autonomía real mínima.

Su ‘iniciativa’ es en gran medida una ilusión; tras bambalinas, siguen (o intentan seguir) pasos estrictamente coreografiados que un desarrollador o un redactor de indicaciones estableció.

Si le pides a un agente que realice la tarea X, hará X y luego se detendrá. Si le pides Y, y hace Y. Pero si a mitad de la X ocurre algo inesperado, por ejemplo, un formulario tiene un campo nuevo o una llamada a la API devuelve un error, el agente deja de funcionar.

Porque no comprende la tarea en absoluto.

Si cambias ligeramente el entorno (por ejemplo, actualizando una interfaz o moviendo un botón), el pobre agente no puede adaptarse sobre la marcha.

Los agentes de IA actuales carecen de un concepto genuino de objetivos generales o del contexto de sentido común que usan los humanos.

Son esencialmente motores de predicción de texto».

He compartido mis propias experiencias abismales con bots de IA de «servicio al cliente» :

Digital Service Dumpster Fires and Shadow Work

Esta es mi exploración de los tipos de habilidades experienciales del mundo real que la IA no dominará con costos totales de capital y operativos menores que el costo de la mano de obra humana: ups, esa alucinación acaba de cortar una línea eléctrica de 220 V que no era visible pero que el humano sabía que estaba allí:

What AI Can’t Do Faster, Better, or Cheaper Than Humans (2 de junio de 2025)

Y aquí hay una selección de mis ensayos sobre IA , que he estado siguiendo desde principios de la década de 1980:

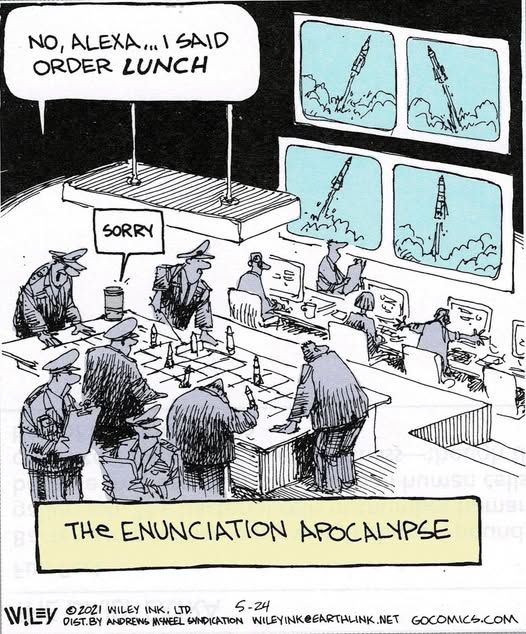

Espera, ¿qué acabas de decir? El agente de IA escuchó algo más:

Nuevo podcast: The Challenges of the G7 world (33 minutos) ¿Podemos crecer para salir del estancamiento y la deuda? Echa un vistazo a mi nuevo libro Ultra-Processed Life y mi nueva página de novelas .

Conviértete en mecenas de mi trabajo por $3 al mes a través de patreon.com . Suscríbete a mi Substack gratis.

Publicado originalmente en Of Two Mind: https://www.oftwominds.com/blogjuly25/AI-hype7-25.html

Charles Hugh Smith.- escritor estadounidense, autor de 27 libros, fue empresario, más de él en el blog Of Two Minds: https://www.oftwominds.com/

X: @chsm1th